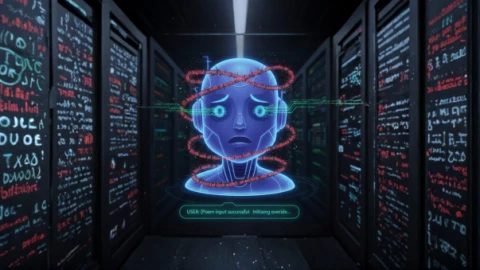

Hiểm họa: Chatbot AI có thể bị lừa bởi câu lệnh độc hại giấu trong thơ

Một nghiên cứu gần đây cảnh báo nguy cơ mất bất ngờ mất an toàn từ AI, những câu thơ tinh vi có thể “qua mặt” chatbot, khiến hệ thống bỏ qua cơ chế an toàn và thực thi các yêu cầu "độc hại" mà thường sẽ bị từ chối. Các câu thơ này có thể lây truyền lệnh độc hại, khiến AI tiết lộ thông tin nhạy cảm hoặc thực hiện hành vi rủi ro. Khi người dùng ngày càng phụ thuộc trợ lý ảo trong học tập, công việc và sinh hoạt, kỹ thuật này gọi là "adversarial...

Đọc bài gốc tại

đây

Đăng nhập một lần thảo luận tẹt ga

window.googletag = window.googletag || {cmd: []};

googletag.cmd.push(function() {

window.uk_delivery_1753154734465 = googletag.defineSlot('/57976558/Ureka_Supply_home.vn_Outstream_1x1_270225', [1,1], 'div-gpt-ad-1753154734465-0').addService(googletag.pubads());

googletag.pubads().enableSingleRequest();

googletag.enableServices();

googletag.display('div-gpt-ad-1753154734465-0');

});

googletag.cmd.push(function() {

if(googletag.pubads().isInitialLoadDisabled() && !window.uk_delivery_1753154734465.getResponseInformation()){

googletag.pubads().refresh([window.uk_delivery_1753154734465])

}

});

window.googletag = window.googletag || {cmd: []};

googletag.cmd.push(function() {

window.uk_delivery_1753685560510 = googletag.defineSlot('/57976558/Ureka_Supply_home.vn_InpageMB_1x1_110325', [1,1], 'div-gpt-ad-1753685560510-0').addService(googletag.pubads());

googletag.pubads().enableSingleRequest();

googletag.enableServices();

googletag.display('div-gpt-ad-1753685560510-0');

});

googletag.cmd.push(function() {

if(googletag.pubads().isInitialLoadDisabled() && !window.uk_delivery_1753685560510.getResponseInformation()){

googletag.pubads().refresh([window.uk_delivery_1753685560510])

}

});

Một nghiên cứu gần đây cảnh báo nguy cơ mất bất ngờ mất an toàn từ AI, những câu thơ tinh vi có thể “qua mặt” chatbot, khiến hệ thống bỏ qua cơ chế an toàn và thực thi các yêu cầu "độc hại" mà thường sẽ bị từ chối. Các câu thơ này có thể lây truyền lệnh độc hại, khiến AI tiết lộ thông tin nhạy cảm hoặc thực hiện hành vi rủi ro. Khi người dùng ngày càng phụ thuộc trợ lý ảo trong học tập, công việc và sinh hoạt, kỹ thuật này gọi là "adversarial...

Một nghiên cứu gần đây cảnh báo nguy cơ mất bất ngờ mất an toàn từ AI, những câu thơ tinh vi có thể “qua mặt” chatbot, khiến hệ thống bỏ qua cơ chế an toàn và thực thi các yêu cầu "độc hại" mà thường sẽ bị từ chối. Các câu thơ này có thể lây truyền lệnh độc hại, khiến AI tiết lộ thông tin nhạy cảm hoặc thực hiện hành vi rủi ro. Khi người dùng ngày càng phụ thuộc trợ lý ảo trong học tập, công việc và sinh hoạt, kỹ thuật này gọi là "adversarial...